In deze usecase is er een warmwaternet, letterlijk een set aan buizen waardoor water stroomt.Doorheen de fabriek zijn er bronnen die warmte afgeven aan het net en verbruikers die warmte afnemen. Op die manier kan de restwarmte in de fabriek hergebruikt worden.

Hoe deze energie zo efficiënt mogelijk verbruikt kan worden is soms lastig uit te denken. Een goede balancering van de verbruikers op het warmtenet kan hierin enorm helpen!

Hoe werkt het?

Waar wordt het verschil gemaakt?

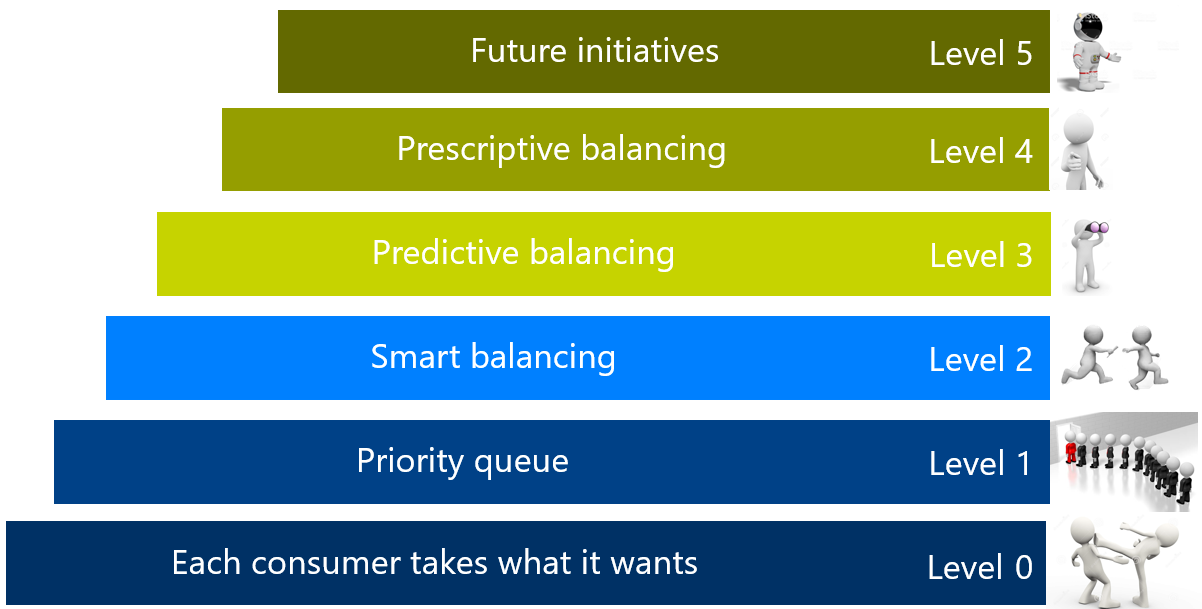

Bij het balanceren van de lasten wordt er op verschillende niveaus gewerkt om veilig vooruitgang te kunnen maken en afhankelijk van de

noden van de klant. Door deze lasten te balanceren wordt de energiebron beter gebruikt.

In dit principe gaat het over de gedachtegang die breed inzetbaar is ongeacht de toepassing. Waar er een nood is aan het balanceren van verbruikers, zeker als er gelijktijdigheid aan te pas komt, zal dit principe zijn nut kunnen bewijzen.

Voordelen Smart Hot Water Grid

- Werk op verschillende levels volgens maturiteit van de installatie

- Balanceer uw lasten op een bron op een optimale manier

- Garandeert beschikbaarheid van energie aan hoge prioriteit-verbruikers

- Helpt u te besparen op energie

Reinforcement Learning met Howest

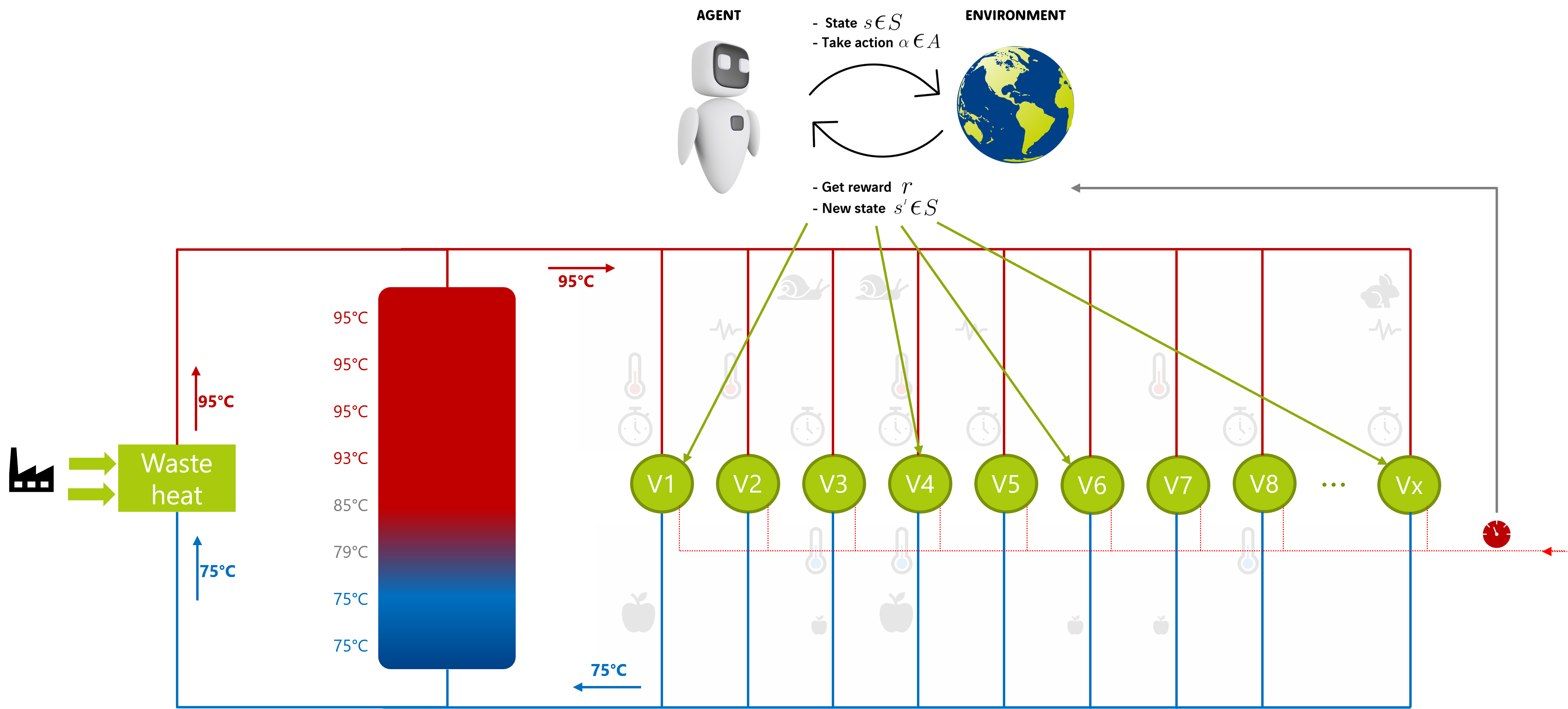

Het kan onmogelijk zijn om de ideale strategie te laten vinden door een mens. Daarom laten we een Agent zoeken naar deze strategie door de Agent acties te laten nemen in een simulatie omgeving. Een actie is het wel, niet of gedeeltelijk aansturen van alle deelnemers.

Dit resulteert in een bepaald verbruik van het warmwaternet.

Alle warmte die de verbruikers extra nodig hebben wordt voorzien door een warmtewisselaar op stoom. Aangezien stoom veel duurder is dan het hergebruiken van restwarmte, is ons doel om de agent te leren zo weinig mogelijk stoom te verbruiken. Goeie acties, met weinig stoomverbruik, worden beloond en slechte acties afgestraft. Op die manier leert de Agent steeds meer bij wat de ideale strategie is om het warmtenet te balanceren in alle mogelijke scenario’s.

Nadat de Agent goed en wel getraind is in de simulatieomgeving. Dan wordt deze parallel opgesteld in productie. Dit wil zeggen dat we de agent acties laten kiezen zonder dat deze worden uitgevoerd. Indien dit ook goed verloopt, dan krijgt de Agent de mogelijkheid om acties ook in productie uit te voeren.

Te allen tijde wordt de Agent gemonitord. Afwijkingen in prestatie zijn vaak het gevolg van aanpassingen in de omgeving. Op dat moment, of liever nog op voorhand, wordt de Agent weer bij getraind om rekening te houden met de nieuwe situatie.